Da wird von Datenbanken gesprochen, von neuronalen Netzen, von festgelegten Parametern, von Mustern und Algorithmen, von semantischen Analysen oder von Machine Learning. Wir benutzen dieses Vokabular selbstverständlich, doch irgendwie bleibt es abstrakt. Elektrische Impulse rasen durch feinste Datenleitungen, sammeln auf Computerspeichern abgelegte Daten, verknüpfen sie erneut, systematisieren sie. Heraus kommt eine bestimmte Information oder vielleicht sogar ein verständlich geschriebener Text, der sich kaum von dem unterscheidet, den ein Mensch geschrieben hat. Das Ganze in Sekundenschnelle. Es macht uns Angst, wenn wir hören, dass das Ding auch noch selbstständig lernen kann. Und es fasziniert uns zugleich, weil es ja irgendwie zu funktionieren scheint.

Kollege Roboter ist nicht perfekt

Meistens jedenfalls. „regex not matched <h3>(.*)<\/h4>“ lautet die Dachzeile einer Feinstaubmeldung auf der Seite der Stuttgarter Nachrichten vom 21. November 2019. Die Überschrift sieht ähnlich aus. Es ist ein Bug, Kollege Roboter ist eben nicht perfekt. Die Stuttgarter Zeitung gehört zu den Vorreitern im Einsatz von automatisierten Redaktionssystemen und wird mit ihren innovativen Projekten Feinstaubalarm und Crimemap gerne im Zusammenhang mit Roboterjournalismus genannt.

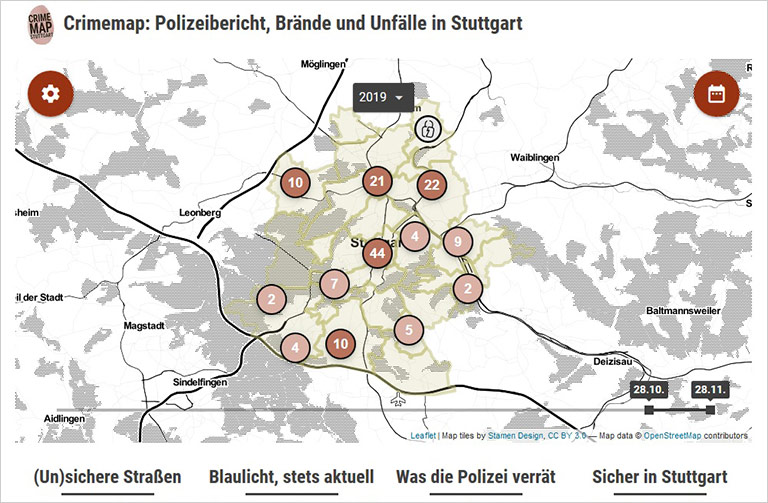

Hinter den beiden Projekten steckt unter anderem der junge Journalist Jan Georg Plavec, der die Idee dazu hatte und sie mit entwickelt hat. Crimemap war das erste redaktionelle Projekt der Stuttgarter Zeitung, das auf Künstlicher Intelligenz (KI) basiert. Die Zeitung selbst beschreibt es so: Der Computer wird mithilfe von sogenanntem Machine Learning trainiert, Polizeitexte aus dem Polizeipräsidium Stuttgart zu verstehen. Dabei sortiert das System sie in vorgegebene Kategorien ein und erkennt, wann und wo ein Ereignis stattgefunden hat. Das Ergebnis ist unter anderem eine Karte auf der Seite der Stuttgarter Zeitung (www.stuttgarter-zeitung.de/crimemap), die die Polizeistatistik quasi emotionslos für die einzelnen Stadtbezirke darstellt.

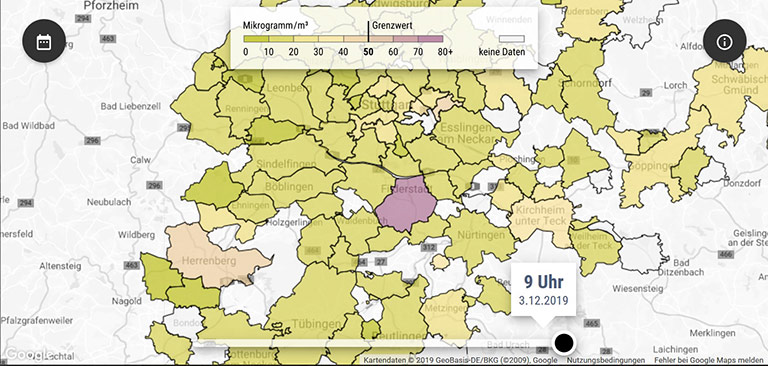

Der Feinstaubalarm, das bekanntere der beiden Projekte, kam später hinzu. Dabei fließen automatisiert Feinstaubinformationen aus den verschiedenen Stadtbereichen zusammen. Auf dieser Basis visualisiert das System die aktuellen Belastungen und verschriftlicht sie tagesaktuell. Dieses Projekt lässt sich dem „Journalismus der Dinge“ zuordnen, in dem Sensoren eine wesentliche Rolle spielen (Näheres dazu hier).

So etwas zu realisieren „geht aber nur im Team“, sagt Plavec. „Bei beiden Projekten waren unser Webentwickler Christian Frommeld, der Grafiker Oliver Biwer sowie meine Chefin Stefanie Zenke mit im Boot, dazu die jeweiligen Fachredakteure. Außerdem bei der Crimemap unser Technikpartner Arvato, von dem auch die KI fürs Auslesen der Polizeimeldungen kommt.“

Die Redaktion in Stuttgart habe die Technologien bisher stets behutsam eingesetzt, berichtet Jan Georg Plavec. „Und davor intensiv redaktionell diskutiert, was geht und was nicht geht, was gewollt ist und was nicht. Bei Polizeimeldungen beispielsweise verzichten wir mit Blick auf unsere redaktionsinternen Richtlinien und nicht zuletzt auch aus inhaltlichen Gründen bewusst auf eine Erhebung von Nationalitäten. Am Ende hilft die Technik uns, neue Entwicklungen und Geschichten zu finden, Informationslücken zu schließen sowie Themen zu setzen.“

Trotz des hohen Grades an automatisierten Vorgängen und Rechenprozessen, an denen nur Software oder elektronische Sensoren beteiligt sind, führt kein Weg am Menschen vorbei. „Für die Feinstaubtexte kann ich sagen, dass die Templates zu 100 Prozent von mir entwickelt worden sind. Auch bei der Crimemap macht die Software letztlich genau das, was wir Journalisten ihr auftragen. Somit würde ich sagen, dass in unseren Projekten ziemlich viel Mensch steckt.“ Vom System werden die Daten ausgelesen und systematisiert, vom Menschen aber bewertet und interpretiert.

Der oben erwähnte kryptische Ausdruck in den Feinstaubmeldungen „kommt übrigens zustande, wenn die Textmaschine einen unvollständigen Feinstaubbericht an unser Online-CMS sendet“, erklärt Plavec. „Die ‚Lücken‘ im Text werden dann mit dem regex-Ausdruck ‚aufgefüllt‘.“ Nachdem die Redaktion manuell eingegriffen hat, läuft das System einen Tag später wieder reibungslos. So, wie es erwartet wird.

Redaktion früh einbeziehen

Einzelnen Projekten können viele Medienschaffende durchaus etwas abgewinnen. Aber als Ganzes schürt die Entwicklung Unsicherheit, viele Journalistinnen und Journalisten sorgen sich, dass sie zu algorithmengetriebenen Contentproduzenten werden sollen. Dabei ist vielerorts auch eine gewisse Technikfeindlichkeit zu spüren. Wie kann man der in den Redaktionen begegnen? „Die Redaktionen frühzeitig in den Prozess miteinzubeziehen ist unserer Erfahrung nach ein sehr entscheidender Faktor, um die Akzeptanz von neuen Technologien zu unterstützen“, erklärt Fabian Michel, Communications Manager von Retresco. Der Anbieter von KI-Software arbeitet mit verschiedenen Redaktionen zusammen und entwickelt automatisierte Systeme für KI-Projekte. Für Michel ist klar, dass ein solcher digitaler Wandel Zeit braucht. „Zudem ist es wichtig, bei jedem Schritt eng mit den Redaktionen zusammenzuarbeiten, um möglichen Bedenken gleich zu begegnen und diese offen zu thematisieren.“

Von Technikfeindlichkeit ist in Stuttgart nichts zu spüren. „Mir selbst geht es oft so, dass ich beim abstrakten Nachdenken über KI und Algorithmen skeptisch werde“, erklärt Jan Georg Plavec. „Wenn Sie sich unsere beiden Projekte näher anschauen, fallen solche Befürchtungen schnell in sich zusammen. Die Technik hilft uns beim konkreten Produzieren von Feinstaubtexten, die sonst nicht geschrieben würden und die ich mit Blick auf die Masse an Texten auch keinen Menschen schreiben lassen möchte. Bei der Crimemap erstellen wir von der Technik unterstützt unsere eigene Datenbank, die uns gemeinsam mit der Kartendarstellung bei der Recherche hilft und unsere Berichterstattung anreichert. Ich sehe zumindest hier in der Redaktion keineswegs die Entwicklung, dass die Kolleginnen und Kollegen sozusagen inspiriert von der Automatisierung zum massenhaften Produzieren von Content gedrängt werden.“

Entlastung von Routineaufgaben

Plavec kann dem Roboter als Kollegen gerade für Routineaufgaben viel abgewinnen. „Es ist eine faszinierende Technik, mit der Sie 80 oder – wenn Sie mögen und die Daten haben – auch 10 000 Texte am Tag automatisiert, aber nach Ihren eigenen Vorgaben schreiben lassen können.“ Man könne „nach einer gewissen Entwicklungsphase automatisiert Tausende Polizeimeldungen auslesen und so zu einer Datenbasis kommen, wie sie die Polizei der Öffentlichkeit hierzulande leider vorenthält“. Die Polizeiliche Kriminalstatistik werde nur einmal im Jahr und bestenfalls für ganze Städte publiziert, nicht aber beispielsweise für Stadtbezirke.

Den Haupteinsatz der Systeme sehen Experten überall dort, wo viele Routinetexte anfallen. Das Wirtschaftsmagazin Forbes lässt täglich automatisiert Börseninfos generieren. Auch die Nachrichtenagentur Associated Press nutzt kleine automatische Programme, um Kursentwicklungen und Quartalsbilanzen zu veröffentlichen.

Ein weiteres beliebtes Einsatzfeld ist der Fußball. Ob Spielberichte aus den Kreisklassen oder Liveticker der 1. Bundesliga – unermüdlich sammeln die Maschinen Infos, werten Daten aus und veröffentlichen Spielgeschehen und Ergebnisse. Sogar Floskeln fließen in die Beiträge ein, das soll sie „menschlicher“ machen. Auf entsprechende KI-Software setzen zum Beispiel das Online-Projekt FussiFreunde, die WELT und der Kicker.

Aber auch hier zeigt sich, dass die Maschine nicht unfehlbar ist. Die Begegnung des Regionalligisten Wuppertaler SV und der U23 von Borussia Dortmund wurde wegen heftiger Unwetter in Wuppertal nach zwölf Spielminuten abgebrochen. Als Spielergebnis wurde 0:0 publiziert. Der generierte Spielbericht verriet nichts über den Abbruch. Solche Spielberichte basieren auf Liga-, Spiel- und Vereinsdaten, die jemand ins System eingibt. Hier hatte der Datenlieferant den Hinweis „Abbruch“ vergessen. In komplex arbeitenden Systemen können eben Fehler vorkommen. Einer Zukunft der Roboter in den Redaktionen steht das kaum entgegen.

Denn der unermüdliche Kollege sorgt auch dafür, dass nahezu alles automatisch analysiert wird: SEO-Tags, Social-Media-Beiträge zu bestimmten Themen, der Frauenanteil in den Artikeln, Autorenrankings, redaktionelle Text- und Bildbeiträge von Mitbewerbern oder Foreneinträge. Je komplexer die Analysetools im Hintergrund arbeiten, desto größer die Mengen an verwertbaren Daten. Nutzerverhalten, beliebte Themen, Suchbegriffe, Twitter, Instagram und Co. – Userin und User sind längst ein offenes Buch und liefern der Redaktion wertvolle Hinweise. Was früher mühsam und zeitintensiv von Hand gemacht wurde, geschieht heute in Echtzeit und hat direkten Einfluss auf die Berichterstattung.

Besonders konsequent orientiert sich die schwedische Zeitung Svenska Dabladet an Algorithmen und deren Analysen. Der redaktionelle Fokus muss auf die Themen gelegt werden, die Userinnen und User am meisten schätzen. Was für sie relevant ist und im Echtzeitranking ganz oben steht, wird bevorzugt bedient. Da fällt es schwer, eigene Themen gegen den von Maschinen erfassten Trend zu setzen: Die Nische kann dabei untergehen.

Links zum Thema KI

• Wissenschaftsjahr 2019 mit Schwerpunktthema KI

www.wissenschaftsjahr.de

• KI-Landkarte Deutschland – Anwendungen und Entwicklungsprojekte

www.plattform-lernende-systeme.de/ki-in-deutschland.html

• Video-Fakes

www.niessnerlab.org

• Texte

Stand der Dinge zu GPT-2: https://openai.com/blog/gpt-2-6-month-follow-up/

Technischer Report „Release Strategies and the Social Impacts of Language Models“: https://d4mucfpksywv.cloudfront.net/GPT_2_August_Report.pdf

Kennzeichnung schafft Transparenz

In Nordrhein-Westfalen beschäftigt sich zum Beispiel RP Online mit Roboterjournalismus. Redaktionsleiter Robert Leurs kann sich „gut vorstellen, dass Automatisierung künftig redaktionelle Prozesse übernimmt oder erleichtert – auch bei uns“. Ein Thema für ein konkretes Projekt nennt er zwar noch nicht, aber ein Detail steht bereits fest. Leurs und seine Kolleginnen und Kollegen sind „überzeugt, dass eine transparente Kennzeichnung dabei zwingend ist“.

Das entspricht dem Bedürfnis vieler Menschen, wie eine Umfrage zeigte, die Statista und nextMedia.Hamburg im Vorfeld des Scoopcamps 2019 in Hamburg gemacht hatten. Danach sprechen sich 77 Prozent der Befragten dafür aus, KI-Anwendungen kenntlich zu machen.

Auch der DJV hält die Kennzeichnung KI-generierter Texte für ein wichtiges Instrument zur Wahrung der journalistischen Glaubwürdigkeit und hatte bereits auf dem Verbandstag 2018 eine Kennzeichnungspflicht gefordert. Die Kennzeichnung darf nach Überzeugung des DJV keine freiwillige Angabe sein, wie sie die Stuttgarter Zeitung bereits als Hinweis zu ihren automatisierten Texten liefert, sondern muss im Pressekodex verankert werden.

Der Anbieter Retresco spricht sich ebenfalls „für Transparenz bei der Verwendung all unserer Produkte und somit für eine Kennzeichnungspflicht“ aus, wie Fabian Michel erklärt: Dies bringe vor allem Vorteile mit sich. Die Transparenz baue Vertrauen auf und steigere die Akzeptanz der Leser. „Das führt letztlich dazu, dass Roboterjournalismus nicht als Bedrohung, sondern als Bereicherung empfunden wird.“

Bleibt die Frage, wie sich der Einsatz vielfältiger automatisierter Systeme auf das Berufsbild des Journalisten auswirken wird. Müssen Journalistinnen und Journalisten mittlerweile sehr gute IT-Kenntnisse haben, wenn Daten über neue Redaktionstools eingesammelt und ausgewertet werden? Zu Teilen, meint Fabian Michel: Wer im Datenjournalismus arbeite, brauche „sicherlich ein deutlich umfangreicheres Verständnis von IT“. Dagegen müssten sich die Kenntnisse von klassischen Journalistinnen und Journalisten nicht gravierend ändern. Zudem sei es das Bestreben des Anbieters, „die Technologie auch ohne IT-Kenntnisse für Journalisten nutzbar zu machen, um sie – besonders in repetitiven Arbeiten – zu unterstützen.“ Umfangreiche „Onboarding Workshops“ mit Erklärung der komplexeren Prozesse sollen zudem sicherstellen, „dass die Technologie für jeden anwendbar ist“.

Allerdings sollten Redaktionen sich nicht blindlings darauf verlassen, dass die Systeme schon das Richtige machen. Das zeigt nicht zuletzt die aktuelle Diskussion, wie Künstliche Intelligenz und selbstlernende Algorithmen etwa durch eine verzerrte Datenbasis auch Vorurteile eingepflanzt bekommen (können).

OpenAI – der nächste Schritt

Dabei sind heutige Robortertexte erst ein kleiner Anfang gemessen an dem, womit Redaktionen sich künftig befassen müssen. Eine neue Dimension in Sachen Texterkennung und Verfassen von Texten bietet unter anderem eine Software, die in Kalifornien entwickelt wurde. Zurzeit wird sie nur zu Forschungszwecken genutzt. Im Februar 2019 stellte das Unternehmen OpenAI das sogenannte Large-Scale Unsupervised Language Model GPT-2 vor.

Diese KI-Software soll nach kurzer Anlernphase in der Lage sein, zusammenhängende Texte zu verfassen, wie es vorher nicht möglich gewesen ist. Sie soll ohne vordefinierte Textblöcke oder Themenumfelder funktionieren und eine Textqualität liefern, die der von menschengeschriebenen Beiträgen ähnelt.

Obwohl OpenAI als Non-Profit-Unternehmen arbeitet, entschieden sich die Entwickler zunächst, die Software nicht als Open Source zu veröffentlichen. Sie sahen die Gefahr, dass ihre KI zur automatisierten Erstellung von Fake News oder für andere Manipulationen in sozialen Medien genutzt wird.

Im August 2019 veröffentlichte das Unternehmen doch noch eine Open-Source-Version, aber nur für eingeschränkte Nutzer. Verschiedene Forschungseinrichtungen untersuchen dieses sogenannte Staged Release nun auf seine Auswirkungen und testen beispielsweise, wie gut Menschen und Technologien die künstlichen Texte erkennen. Weitere Forschungsfragen: Welche sozialen Auswirkungen haben die künstlich erstellten Texte? Und wie können wir künftig mit nützlichen oder schädlichen Anwendungsbereichen umgehen? Erste allgemeine Ergebnisse sind bereits im technischen Report „Release Strategies and the Social Impacts of Language Models“ eingeflossen, der im Netz abrufbar ist.

GPT-2 soll keine reine Forschungssoftware bleiben. Abhängig von den Ergebnissen des Reports ist eine Veröffentlichung geplant. Dabei zeigt der Umfang an Datensätzen für die Texterstellung, wie rasant sich die Software entwickelt: Von anfangs über hundert Millionen Parametern sollen es jetzt mehr als 1,5 Milliarden Parameter sein, die von der KI zur Texterstellung herangezogen werden. Sie wird dadurch immer perfekter, sodass Grenzen zwischen von Menschen oder Computer erstellten Texten zunehmend verwischt werden.

Faktenchecken und Verifizieren

Das stellt Redaktionen genauso wie Userinnen und User künftig vor noch größere Herausforderungen. Was ist echt, was ist Fake? Das betrifft nicht nur Texte und schriftliche Quellen, sondern auch Fotos, Videos und Audiodaten. In Zukunft heißt es, noch genauer hinzuschauen, was veröffentlicht wird oder als Recherche-Quelle dient. Auch bei der Erkennung von gefälschtem oder manipuliertem Material wird Hoffnung auf KI-Software gesetzt. Allerdings funktioniert das bisher noch nicht richtig.

Selbstlernende Algorithmen sind – siehe oben – immer nur so gut, wie ihre Trainingsdaten waren. Um Falschmeldungen und Propaganda zweifelsfrei zu erkennen, bedarf es weiterhin der Kombination aus Machine Learning und menschlicher Urteilskraft. KI-basierte Technik wird dabei helfen, Manipulationen aufzuspüren und Fakten zu checken. Aber vorerst bleibt der Mensch mit seiner Erfahrung und den richtigen Tools der entscheidende Faktor für das Fakten-Checken, das Verifizieren und die Qualitätssicherung in den Redaktionen. Davon sind Expertinnen und Experten überzeugt.

Bitter genug: Besser als das Verifizieren klappt schon heute das maschinenunterstützte Fälschen. Die Art der Manipulationen sind vielfältig. Bereits 2016 präsentierte der Softwarehersteller Adobe auf der Konferenz „Adobe Max“ in San Diego ein Programm, mit dem Sprachaufzeichnungen mit einem Texteditor bearbeitet werden konnten. So würden Tonaufzeichnungen manipulierbar. Zudem sollte es sogar möglich sein, mithilfe einer solchen Software biometrische Sicherheitssysteme auszutricksen, die auf Stimmerkennung basieren. Das Programm wurde bis jetzt nicht veröffentlicht.

Skepsis überwiegt

Statista und nextMedia.Hamburg haben im August 2018 eine Onlineumfrage gemacht. Unter 1 000 Befragten antworteten auf die Frage „Wie stehen Sie automatisierten Nachrichten und Roboterjournalismus gegenüber?“

• Betrachte ich eher skeptisch: 49 Prozent

• Finde ich schlecht: 28 Prozent

• Hängt vom Thema ab: 20 Prozent

• Halte ich sinnvoll: 3 Prozent

Quelle: nextMedia Hamburg

Manipulierte Bewegtbilder und Fotos

Ähnlich neu und brisant sind KI-basierte Manipulationsmöglichkeiten bei digitalen Bewegtbildern. Das zeigt der Youtube-Kanal Ctrl Shift Face, der in den vergangenen Monaten Aufsehen mit sogenannten Deepfake-Videos erzeugt hat. Dabei ersetzt eine Software Schauspieler in berühmten Filmszenen durch andere Darsteller. Aktuell ist es der Film „No Country for Old Men“ der Gebrüder Coen, in dem nun Arnold Schwarzenegger und andere Schauspieler auftreten. Solche Manipulationen sind manchmal noch arg holperig und offensichtlich, aber es wird deutlich, wohin die Reise geht. Nicht nur im Bereich professionelle Videobearbeitung: Es gibt bereits eine Handy-App aus China, mit der auch Privatleute munter Videos manipulieren können, annähernd so wie man es schon von der Fotobearbeitung im Smartphone kennt.

Bilder wurden schon weit vor den digitalen Zeiten manipuliert, und trotzdem stellen sich die Fragen unter den heutigen Bedingungen neu. Etwa im Bildjournalismus: Darf ein Foto durch KI-basierte Programme bearbeitet und verwendet werden? „Tendenziell würde ich sagen: Gar nicht!“, erklärt Wolfgang Birkenstock, Vorsitzender im Fachausschuss Bildjournalisten im DJV-NRW. Und er schiebt nach, dass sich Bildjournalistinnen und -journalisten sich „mit allzu heftigen Eingriffen zurückhalten sollten“.

Dabei wird KI im Bereich Bildbearbeitung durchaus schon eingesetzt. Birkenstock verweist unter anderem auf das Adobe-Projekt Sensei – mit dem erneuten Hinweis, dass sich Bildjournalisten „solche Composings und Retuschen eh verkneifen“ sollten. Auch Luminar werbe mitKI bei der Bildretusche. Selbst einige Redaktionssysteme korrigierten Bilder bereits mehr oder weniger gut, wenn sie nach Ansicht des Algorithmus zum Beispiel zu dunkel oder zu hell seien. Aber das zähle wohl eher nicht, wenn man über KI rede.

Dr. Bernd Seydel, Vorsitzender des Bundesfachausschuss Bild, sieht es ähnlich: „Um es mal ganz hart zu sagen: Jedes Foto ist bearbeitet – kameraintern, durch das Fotografieren und durch den Fotografen. Am Ende zählt für mich: Geht es um wirklichkeitsnahe Bilder oder absichtliche Verfälschung? Zu Letzterem gehört ganz eindeutig die Montage.“

Eine Reihe normaler Funktionen etwa bei Photoshop nutzten bereits mehr oder weniger ausgeprägt Möglichkeiten der künstlichen Intelligenz, erläutert Seydel. Ob Entrauschen, Freistellen oder ähnliche Arbeitsschritte: Überall könnten sich heute – vom Nutzer kaum bemerkt – KI-basierte Prozesse abspielen. Solche Funktionen werden nach seiner Einschätzung immer stärker implementiert werden.

Seydel hält nichts von der Vorstellung, „dass ich meine Kamera hochhalte und diese dann in dem Augenblick auslöst, wo sie selbst glaubt, ein tolles Bild zu fotografieren“. Jedes gute Foto entstamme einer fotografischen Absicht und einem Auftrag, sehr häufig ausgelöst durch andere Menschen, durch eine Redaktion oder Ähnliches. „Ich glaube nicht, dass meine Kamera das jemals verstehen wird.“

Dass KI auch in der Profifotografie helfen kann, bekannte Welten in ein neues Licht zu rücken und der Wirklichkeit viel näher zu kommen, zeigt Scientific America, ein Wissenschaftskanal in den USA. So hat beispielsweise die Ingenieurin und Unterwasserfotografin Derya Akkaynak einen Algorithmus für die Bearbeitung von Unterwasseraufnahmen geschrieben, der nichts mit einer nachträglichen Farbkorrektur gemein haben soll. Schwebeteilchen und Farbstich sollen mit einem Klick verschwinden können und die Unterwasserwelt in ihrer ganzen farbenfrohen Schönheit – wo noch vorhanden – preisgeben. Aus der Sicht von Akkaynak kann diese Technik wertvolle Erkenntnisse liefern, welchen Einfluss der Klimawandel auf Korallenriffe und andere maritime Lebensräume haben kann.

Wenn KI die Kamera bewegt

Ein anderer hilfreicher Aspekt der Automatisierung findet sich in den Robotik-Systemen für Fotografie und Bewegtbildproduktion. Sie werden bereits von großen Fotoagenturen wie AFP oder Getty Images eingesetzt, um zum Beispiel Großveranstaltungen aus möglichst vielen Blickwinkeln zu erfassen. Auch sonst kommen diese KI-gesteuerten Systeme überall dort zum Einsatz, wo Menschen nur stören würden, keinen Zugang haben oder einfach nicht als Fotografin oder Fotograf sichtbar sein sollen.

Der amerikanische Sportfotograf Rob Martin war einer der ersten Anwender, die bei der Bildberichterstattung auf die Hilfe von Robotern zurückgriff. Schon bei Wimbledon 2013 setzte er auf ferngesteuerte Kameras am Stadiondach, die das Geschehen aus verschiedenen Perspektiven im Fokus hatten. Mit KI hatte das allerdings noch nichts zu tun. Die Kameras waren auf einfachen Schienensystemen montiert, die sich aus der Ferne vor- und zurückbewegen ließen, ein beweglicher Stativkopf drehte die Kamera in die richtige Position. Kamerafokus und Auslösung wurden per Funk gesteuert.

Seitdem haben sich Technik und Funktionalität weiterentwickelt. Bei heutigen Systemen verschmelzen Kamera- und Robotiksystem inklusive Software miteinander. Sie können komplexe Bewegungen ausführen und verfügen über eine ausgefeilte Trackingsoftware für Augen, Gesicht und Körperbewegungen. Menschen werden individuell erfasst und bekommen praktisch ein eigenes Bewegungsprofil.

Die Person bleibt im Fokus

Viel Technik, wenig Mensch – das könnte das Motto im Broadcasting in Kombination mit KI sein. Was dort technisch möglich ist, zeigt ein System, das im September 2019 auf der IBC (International Broadcasting Convention) in Amsterdam präsentiert wurde: das Polymotion-Chat-System von Nikon und Mark Roberts Motion Control. Sein Einsatzzweck „sind Studioumgebungen, wie ein Fernsehstudio, um beispielsweise Interviewsituationen einzufangen“, erläutert Marius Merten, Manager Robotic Imaging bei Nikon. „Das System kann mit mehreren Kameras vollautomatisch eine oder auch mehrere Personen im gewünschten Bild halten. Die Robotik schwenkt, neigt oder zoomt die Kamera völlig autonom.“

So könne man zum Beispiel nach dem Festlegen des Motivs eine „statische Zone“ einrichten, um zu steuern, wie weit sich das Motiv bewegen kann, bevor die Kamera ihm folgt. Die Geschwindigkeit dieser Bewegung könne gemäß den Produktionsanforderungen gesteuert werden. Laut Nikon kann das System unabhängig von einer bestimmten Kameramarke eingesetzt werden.

Auch bisher war ein Personentracking schon möglich. Aber die Bewegungen der Kameras waren entweder vorab genau definiert und an bestimmte Vorgaben gebunden oder man steuerte die Kameras manuell. „Die KI-unterstützte Software übernimmt jetzt verschiedene Aufgaben: Personen werden erkannt, das System erfasst Gesichter der zu filmenden Personen, analysiert deren Bewegungsabläufe und bewegt danach die Robotik beziehungsweise die Kameras selbstständig. Der Anwender ist hier eher Regisseur als Kameraoperator“, erklärt Merten. Dies erfordere zudem nur eine Person zur Bedienung.

Für Videojournalisten (VJs) oder für selbstdrehende Reporterinnen und Reporter gibt es ein kostengünstigeres, technisch abgespecktes System, das bei der Live-Berichterstattung gute Dienste leisten kann: App-gesteuerte Systeme, basierend auf Gimbals. Darunter ist eine Art Arm oder aufgehängtes Stativ zu verstehen, das die Kamera oder Handykamera hält und mithilfe der passenden Software und eines Smartphones auch bewegt. So lässt sich ein bewegtes und getracktes System für Videoaufzeichnungen zusammenstellen. Dadurch entsteht eine Amateur-Ausführung des oben dargestellten Profisystems, sodass eine sich bewegende Person von der Kamera auf einem Gimbal verfolgt werden kann.

Bereits vielerorts im Einsatz

Die vielen Beispiele zeigen: Das KI-Zeitalter in den Redaktionen ist bereits angebrochen. Der Kollege Roboter ist vielerorts im Einsatz beziehungsweise einsatzbereit und wartet nur noch darauf, offiziell seinen Dienst aufnehmen zu dürfen. Roboterjournalismus bedeutet, automatisierte Systeme zu betreiben, die die Steuerung von Themenseiten übernehmen, wie Retresco es bereits 2013 mit FAZ.net realisiert hatte. Es bedeutet, Daten zu sammeln und systematisch zu verarbeiten, um damit ohne menschliches Zutun automatisch Beiträge zu veröffentlichen.

Doch ganz ohne Redakteurinnen und Redakteure geht es bisher nicht, und wird es vermutlich auch in Zukunft nicht funktionieren. Damit der Roboter „journalistisch“ tätig sein kann, benötigt das System Hilfe und vor allem menschliche Intuition, um einzuordnen, abzuwägen und den automatisch produzierten Content kritisch zu überprüfen. Vor allem, wenn es um die Kontrolle und das Erkennen von Fake News und Meinungsmache in sozialen Netzwerken mit rassistischen oder Demokratie zersetzenden Kommentaren geht, bleiben Menschen die letzte Instanz.

Eine Stand-alone-Lösung kann KI also (noch nicht) sein. Bis auf Weiteres hält der Mensch die Redaktionsfäden in der Hand, bleibt die Maschine der Assistent. Egal, ob es nur um Feinstaubbelastung oder Manipulationen von Inhalten geht.||

Ein Beitrag aus JOURNAL 6/19, dem Medien- und Mitgliedermagazin des DJV-NRW, erschienen im Dezember 2019.